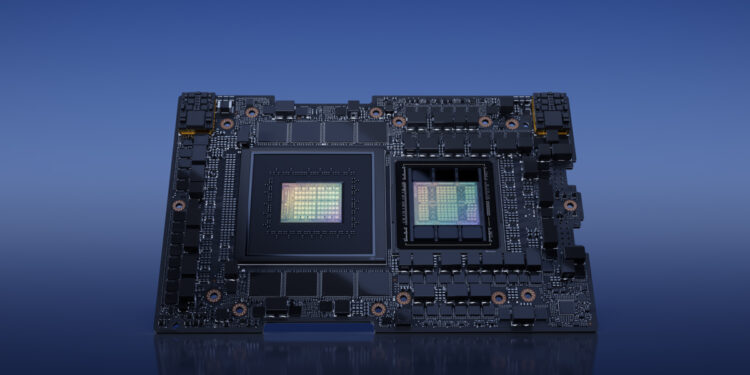

Konferenca NVIDIA në SIGGRAPH 2023 sapo ka përfunduar: nuk ka GPU të reja të lojrave, siç pritej, por ka ende shumë gjëra të reja për të eksploruar, veçanërisht në sektorin e AI. Për shembull, Team Verde sapo ka zbuluar GPU-në e tij GH200 me teknologjinë HBM3e, e cila i garanton komponentit memorien më të shpejtë në treg.

Sipas një njoftimi nga NVIDIA, GPU Hopper GH200 është i pari në botë me teknologjinë HBM3e, e cila garanton memorie me kapacitet më të lartë dhe gjerësi bande më të madhe në krahasim me zgjidhjet aktualisht në treg. GPU GH200 është quajtur kështu sepse përfshin një sistem të dyfishtë Grace Hopper, i cili është i pajisur me dy çipa NVIDIA Grace Hopper GH200 për serverët dhe qendrat e të dhënave, që aktualisht përdoren kryesisht për aplikacione që lidhen me AI gjeneruese.

Mundësuar nga teknologjia HBM3e, GPU Hopper GH200 jep deri në 3x gjerësinë e brezit dhe 3,5x kapacitetin e memories së çipave GH100. Në total, çipi Team Verde vjen me deri në 282 GB memorie HBM3e. Krahasuar me standardin HBM3, HBM3e premton të arrijë 50% shpejtësi më të larta dhe, mbi të gjitha, të garantojë një gjerësi brezi deri në 10 TB/s për GPU dhe deri në 5 TB/s për secilin nga dy çipat e lidhur.

Sipas njoftimit zyrtar për shtyp të NVIDIA, “Platforma NVIDIA GH200 Grace Hopper është ndërtuar për epokën e llogaritjes së përshpejtuar dhe AI. E ndërtuar për të përballuar ngarkesat më të kërkuara të punës në lidhje me AI gjeneruese, platforma e re do të jetë e disponueshme në një numër të madh konfigurimesh” . Për momentin, për fat të keq, nuk e dimë se kush do t’i furnizojë kompanisë memoriet HBM3e, megjithëse në mesin e emrave në tryezë do të ishin kompanitë koreane SK Hynix dhe Samsung.

Më në fund, NVIDIA ka njoftuar se GPU-të Hopper GH200 do të jenë të disponueshme në tremujorin e dytë të 2024, pra midis prillit dhe qershorit të vitit të ardhshëm. Në këtë mënyrë, kartat AI do të përplasen drejtpërdrejt me GPU-të AMD Instinct MI300X, të cilat megjithatë do të montojnë HBM3 VRAM me një kapacitet maksimal prej 192 GB.

Discussion about this post