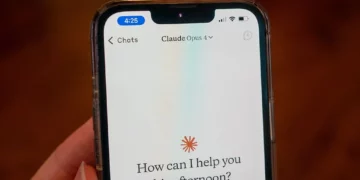

OpenAI njoftoi disa veçori të reja për GPT-3.5-turbo dhe GPT-4. Të dy modelet e AI tani mbështesin funksionalitetin e “thirrjes së funksionit”, i cili i lejon zhvilluesit të menaxhojnë më mirë të dhënat e strukturuara dhe të krijojnë chatbot që përdorin mjete të jashtme për t’iu përgjigjur kërkesave. Kostot për përdorimin e GPT-3.5-turbo gjithashtu u ulën.

Te reja për GPT-3.5-turbo dhe GPT-4

GPT-3.5-turbo është modeli i aksesueshëm për të gjithë nëpërmjet ChatGPT, ndërsa GPT-4 është i rezervuar për abonentët Plus (por është i disponueshëm me Bing Chat). Me mbështetjen për thirrjen e funksionit, zhvilluesit mund të përshkruajnë funksione që modelet do të përdorin për t’iu përgjigjur kërkesave më komplekse.

Për shembull, mund të krijoni chatbot që thërrasin mjete të jashtme (përfshirë shtojcat), konvertojnë gjuhën natyrore në thirrje API ose nxjerrin të dhëna nga një bazë të dhënash nëpërmjet pyetjeve. Funksioni ju lejon gjithashtu të merrni dalje në format JSON. Risia përfshihet në modelet GPT-3.5-turbo-0613 dhe GPT-4-0613 (për të përdorur API-të e këtij të fundit, kërkohet regjistrimi në listën e pritjes.

OpenAI njoftoi gjithashtu versione të dy modeleve me një “context window” më të madhe. Termi i referohet kujtesës afatshkurtër, e cila është gjatësia e tekstit që konsiderohet të japë një përgjigje. GPT-3.5-turbo-16K dhe GPT-4-32K kanë një dritare konteksti prej 16,000 dhe 32,000 argumentesh, respektivisht.

Së fundi, kompania kaliforniane uli çmimin e tokenave të GPT-3.5-turbo, modeli më i përdorur, me 25%. Zhvilluesit tani do të paguajnë 0,0015 dollarë për 1000 argumente hyrëse dhe 0,002 dollarë për 1000 tokena dalës. Përdorimi i modelit GPT-3.5-turbo-16K do të kushtojë 0,003 dollarë për 1,000 shenja hyrëse dhe 0,004 dollarë për 1,000 argumente dalëse.

Discussion about this post