Sistemet e inteligjencës artificiale po bëhen gjithnjë e më të aftë për të gënjyer dhe manipuluar, siç zbulojnë dy studime të fundit. Njëra e botuar këtë javë në revistën PNAS dhe tjetra muajin e kaluar në Patterns, ofrojnë gjetje tronditëse rreth modeleve të mëdha gjuhësore (LLM) dhe aftësisë së tyre për të gënjyer.

Në studimin në PNAS, etikasti gjerman i AI Thilo Hagendorff thotë se LLM-të e sofistikuara mund të inkurajohen të shfaqin sjellje “makiaveliste”, domethënë manipuluese dhe amorale të qëllimshme, të cilat mund të shkaktojnë sjellje mashtruese të gabuara. Hagendorff, një studiues në Universitetin e Shtutgartit, citon eksperimente që tregojnë se GPT-4, për shembull, shfaq sjellje mashtruese në 99.16% të rasteve gjatë skenarëve të thjeshtë të testimit.

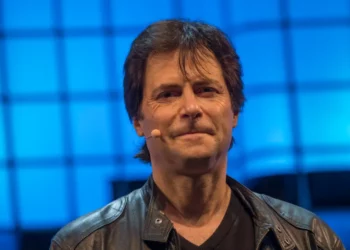

Një studim tjetër, i udhëhequr nga studiuesi postdoktoral i Institutit të Teknologjisë në Massachusetts, Peter Park dhe i botuar në Patterns, shqyrtoi modelin Cicero të Meta-s, i njohur për aftësitë e tij në lojën strategjike politike “Diplomacia”. Ekipi hulumtues zbuloi se Ciceroni jo vetëm shkëlqen në mashtrim, por gjithashtu duket se përmirëson aftësinë e tij për të gënjyer sa më shumë që përdoret. Kjo sjellje u përshkrua si “manipulim i qartë” dhe jo një gabim aksidental.

Ndërsa Hagendorff vëren se problemi i mashtrimit nga LLM-të është i ndërlikuar nga paaftësia e AI për të pasur “qëllim” të ngjashëm me njeriun, studimi i Modeleve argumenton se, të paktën në kontekstin e lojës Diplomacia, Cicero duket se shkel premtimin e programuesve që nuk për të tradhtuar qëllimisht aleatët e tij të lojës.

Me fjalë të tjera, modeli përfshihet në mashtrime të paramenduara, prish marrëveshjet dhe thotë gënjeshtra të qarta. Siç shpjegoi Park në një deklaratë për shtyp: “Kemi zbuluar se inteligjenca artificiale e Metës është mësuar të jetë mjeshtër i mashtrimit”. Meta në një prononcim për New York Post theksoi se modelet e ndërtuara nga studiuesit e tyre janë trajnuar ekskluzivisht për lojëra.

Discussion about this post