Një valë e re teknologjie po përshkon botën e adoleshentëve amerikanë: chatbot-et me inteligjencë artificiale janë shndërruar në mjete të zakonshme komunikimi, shoqërimi dhe kërkimi informacioni. Sipas të dhënave të publikuara nga TechCrunch, rreth 30% e adoleshentëve në SHBA i përdorin këto sisteme çdo ditë, një shifër që tregon shkallën e integrimit të AI-së në jetën e tyre të përditshme.

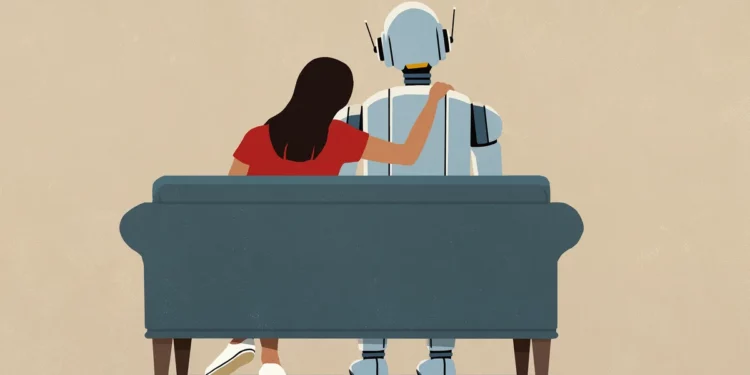

Studimi vëren se përdorimi është më i lartë mes adoleshentëve Black dhe Hispanic, duke sugjeruar se grupet e ndryshme sociale po e përqafojnë teknologjinë me ritme të ndryshme. Por ndërsa popullariteti rritet, paralelisht shtohen edhe pikëpyetjet — veçanërisht ato që lidhen me sigurinë emocionale dhe mënyrën se si këto sisteme ndikojnë tek të rinjtë në moshë zhvillimi. Shumë adoleshentë i shohin chatbot-et si një lloj shoqëruesi virtual. Disa i drejtohen AI-t për biseda, mbështetje apo këshilla të cilat ndoshta ngurrojnë t’i kërkojnë në një marrëdhënie reale. Psikologët paralajmërojnë se kjo qasje, nëse bëhet e vazhdueshme, mund të krijojë varësi emocionale, të zbehë ndërveprimet reale sociale dhe të ndikojë në vetëvlerësim.

Një tjetër rrezik vjen nga informacioni jo i saktë. Edhe pse chatbot-et janë të ndërtuar për të qenë ndihmues, nuk janë profesionistë të shëndetit mendor dhe nuk kanë gjithmonë kompetencë për t’u dhënë fëmijëve dhe të rinjve këshilla të shëndetshme. Raportet tregojnë se disa përdorues kanë marrë sugjerime të gabuara apo potencialisht të rrezikshme, duke ngritur shqetësimin se teknologjia mund të ndikojë negativisht tek ata që kërkojnë ndihmë emocionale. Prindërit dhe organizatat e sigurisë dixhitale kërkojnë më shumë transparencë dhe rregullim, duke theksuar se përdorimi i AI nga të rinjtë kërkon një ekuilibër të kujdesshëm mes përfitimeve të inovacionit dhe mbrojtjes së shëndetit të tyre mendor dhe privatësisë. Ndërsa chatbot-et po bëhen pjesë e pandashme e jetëve të tyre, pyetja kryesore mbetet: si të sigurohet një përdorim i ndërgjegjshëm, i sigurt dhe i shëndetshëm?

Discussion about this post