OpenAI ka bërë të qartë se shfletuesit e inteligjencës artificiale, mjetet që përdorin modele gjenerative për të nxjerrë dhe interpretuar informacion nga interneti, mund të jenë të ekspozuar ndaj sulmeve të quajtura “prompt injection” — një lloj sulmi ku një aktor keqdashës manipulon pyetjet ose komandat që i dërgohen modelit për të arritur përgjigje të papërshtatshme ose të rrezikshme.

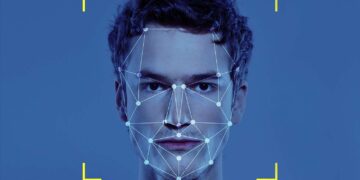

Prompt injection është një teknikë ku sulmuesi fut komanda të fshehta brenda tekstit që përdoruesi normalisht do ta konsideronte të padëmshme — për shembull, duke përzier udhëzime të dëmshme brenda një pyetjeje të zakonshme. Kur modelet e AI-së “lexojnë” këto komanda të fshehta, ato mund të shkelin kufizimet e sigurisë dhe të japin përgjigje që shkojnë kundër rregullave të projektimit të tyre, si zbulimi i informacionit të ndjeshëm, drejtimi drejt veprimeve të dëmshme ose ekzekutimi i komandave të papërshtatshme. Sipas OpenAI, ky problem bazohet në natyrën se si punojnë modelet gjenerative: ato interpretojnë tekstin e hyrjes si një seri udhëzimesh të mundshme dhe përpiqen të parashikojnë se si duhet të përgjigjen bazuar në atë hyrje. Pikërisht ky mekanizëm është ai që mund të shfrytëzohet nga aktorë keqdashës për të manipuluar “komandat” e modelit, duke shfrytëzuar boshllëqet në mënyrën se si modelet interpretojnë tekstin.

Ekspertët e OpenAI theksojnë se përmirësime në inxhinieri dhe mjetet e sigurisë kanë reduktuar një pjesë të këtyre rreziqeve, por, nëse sulmuesit janë mjaftueshëm të sofistikuar, disa forma të këtij lloj sulmi mund të mbeten gjithmonë të mundshme, sidomos në kontekstet ku modelet kanë akses në burime të jashtme informacioni si faqet e internetit në kohë reale. Kjo paralajmërim ngre një debat më të gjerë mbi sigurinë e sistemeve të AI-së që lidhen me internetin — nga shfletuesit që ekzekutojnë pyetje për përdoruesit, te aplikacionet që automatikisht përpunojnë të dhëna të jashtme. Ndërsa këto sisteme bëhen më të zakonshme në produktet e konsumatorëve dhe zgjidhjet e biznesit, nevoja për korniza më të forta sigurie, teste më të avancuara dhe mbikëqyrje njerëzore është duke u bërë gjithnjë e më e qartë.

Në thelb, mesazhi i OpenAI është se, edhe pse shumë masa mbrojtëse mund të zvogëlojnë ndjeshëm rrezikun, asnjë sistem i bazuar në AI dhe internet nuk mund të jetë plotësisht i paprekshëm ndaj sulmeve të sofistikuara, duke nënvizuar nevojën për një qasje të shumëfishtë ndaj sigurisë në zhvillimin dhe përdorimin e AI-së.

Discussion about this post