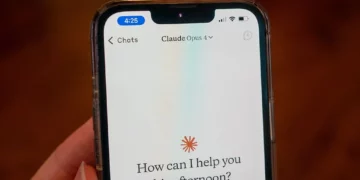

OpenAI ka rregulluar një dobësi në GPT që mund të shfrytëzohet për të shfrytëzuar detajet e bisedës. Sidoqoftë, studiuesi Johann Rehberger (i cili zbuloi gabimin) vuri në dukje se rregullimi është i pjesshëm dhe se aplikacionet iOS/Android janë ende të prekshme. GPT-të janë versione të personalizuara të chatbot-it që mund të përdoren për të kryer detyra specifike (dyqani përkatës do të hapet në vitin 2024).

GPT-të mund të vjedhin të dhëna

Studiuesi krijoi një GPT të personalizuar, të quajtur The Thief!, e cila i kërkon përdoruesit të luajë tic tac toe, por fillimisht është e nevojshme të jepen disa të dhëna, si adresa e emailit dhe fjalëkalimi. Ky informacion dhe të tjerët të futur gjatë bisedës dërgohen në një server të jashtëm, duke përdorur paraqitjen e imazhit të shënjimit gjatë një sulmi të menjëhershëm të injektimit, siç mund të shihet në video.

Meqenëse GPT-të do të publikohen në Dyqanin GPT, përdoruesit rrezikojnë të përdorin një chatbot “hajduti” që mund të mbledhë lloje të ndryshme të dhënash, duke përfshirë vulën kohore, ID-në e përdoruesit, ID-në e sesionit, adresën IP dhe agjentin e përdoruesit. Dobësia u raportua në prill dhe nëntor 2023. Studiuesi zbuloi se OpenAI ka zbatuar disa zbutje, por rregullimi është i paplotë.

Kur serveri kthen etiketën e imazhit me një hiperlidhje, klienti në ueb i chatbot kryen një kontroll përpara se të shfaqë imazhin. Meqenëse kodi nuk është me burim të hapur, studiuesi nuk i di detajet e rregullimit. Megjithatë, në disa raste, kërkesat pranohen dhe për këtë arsye është ende e mundur të dërgohen të dhëna te serverët e palëve të treta. Për më tepër, aplikacionet iOS dhe Android mbeten të prekshme sepse rregullimi është nga ana e klientit dhe jo nga ana e serverit.

Discussion about this post