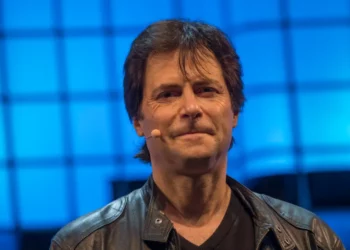

Ashtu si të gjitha sistemet gjeneruese të inteligjencës artificiale, modelet mund të japin rezultate të pasakta ose të papërshtatshme, ne do të vazhdojmë t’i trajtojmë këto probleme dhe të përmirësojmë veçoritë ndërsa evoluojnë”: me këto fjalë, në blogun e saj zyrtar, Meta përpiqet të japë shpjegime në lidhje me problemet. ‘halucinacionet’ që ndodhën në lidhje me sulmin ndaj Donald Trump.

Njëra përfshinte përgjigjet e inteligjencës artificiale që mohonin të shtënat, tjetra një imazh të modifikuar të ish-presidentit, për të cilin sistemet e Metës vendosën gabimisht një etiketë kontrolluese të fakteve.

“Chatbots, duke përfshirë Meta AI, nuk janë gjithmonë të besueshëm kur bëhet fjalë për ofrimin e lajmeve ose informacioneve të fundit në kohë reale, veçanërisht në ngjarjet e fundit kur ka konfuzion, informacione kontradiktore ose teori konspirative të plotë – shpjegon kompania – Në vend që Meta AI të ofrojë të pasakta informacione për atentatin në tentativë, ne thjesht e programuam që të mos u përgjigjej pyetjeve.

Që atëherë i kemi përditësuar përgjigjet e dhëna, por duhet ta kishim bërë më shpejt. Në një numër të kufizuar rastesh, AI vazhdoi të jepte përgjigje të pasakta, halucinacione dhe është një problem në të gjithë industrinë, një sfidë e vazhdueshme se si AI do të trajtojë ngjarjet në kohë reale në të ardhmen.”

Lidhur me foton e doktoruar të Trump me grushtin ngritur që bënte të dukej sikur agjentët e Shërbimit Sekret po buzëqeshnin, Meta shpjegon se “fillimisht u aplikua një etiketë e kontrollit të fakteve sepse zbuloi përmbajtje pothuajse identike me imazhin origjinal. Ekipi ynë punoi për të korrigjoni shpejt këtë gabim Ne po punojmë vazhdimisht për të bërë përmirësime,” përfundon Meta.

Discussion about this post